本文最后更新于1 分钟前,文中所描述的信息可能已发生改变。

阿里云发布最强开源大模型Qwen2,干翻Llama 3,有的地方甚至超过GPT4

说明

阿里云正式开源通义千问Qwen2系列模型,其中,Qwen2-72B成为全球性能最强的开源模型。 在全球权威测评中,性能超过美国最强开源模型Llama3-70B,也超过文心4.0、豆包pro、混元pro等众多中国闭源大模型。

今天带大家在本地自己的电脑上部署安装qwen2模型,一键让你也可以拥有属于自己的大模型,并且安全可靠,毕竟不用将隐私内容上传云端,保证了数据的安全性。

废话不多说,直接开始!

什么是Ollama?

Ollama是一个开源项目,它是一个功能强大且用户友好的平台,可以方便的在本地计算机上运行多种架构的LLM(大语言模型)。它充当了LLM技术的复杂性和简单易用的体验之间的桥梁。 它的项目地址如下:

ollama: https://github.com/ollama/ollama

官方地址:

安装Ollama cli版

ollama cli版是命令行版本,从ollama官网安装的版本默认是命令行版的,可以先看看效果,如果要实际动手,建议安装使用下面有界面交互的版本,使用更加方便

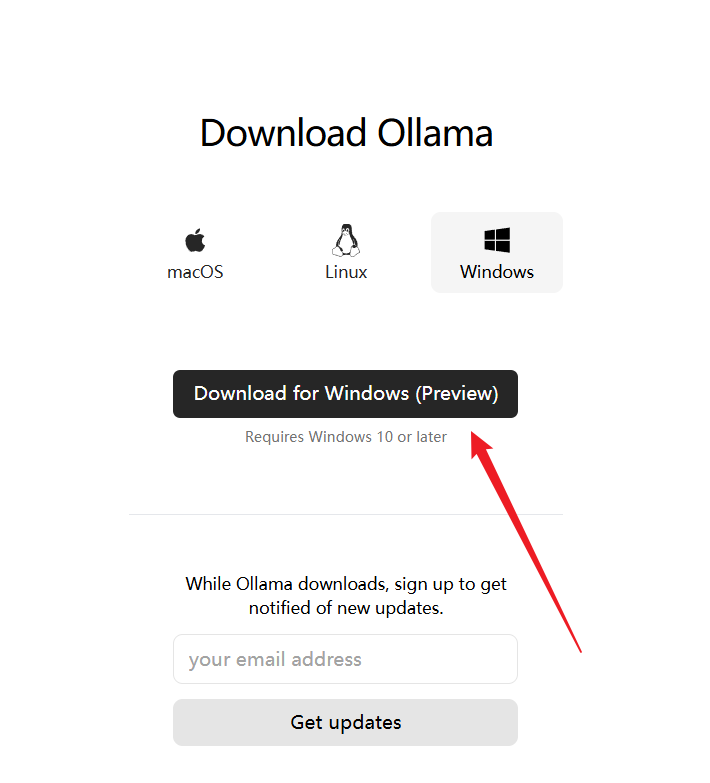

打开ollama的官网,点击中间的Download按钮,选择下载对应系统的安装文件

我是在windows上安装,直接下载。

我是在windows上安装,直接下载。下载安装文件

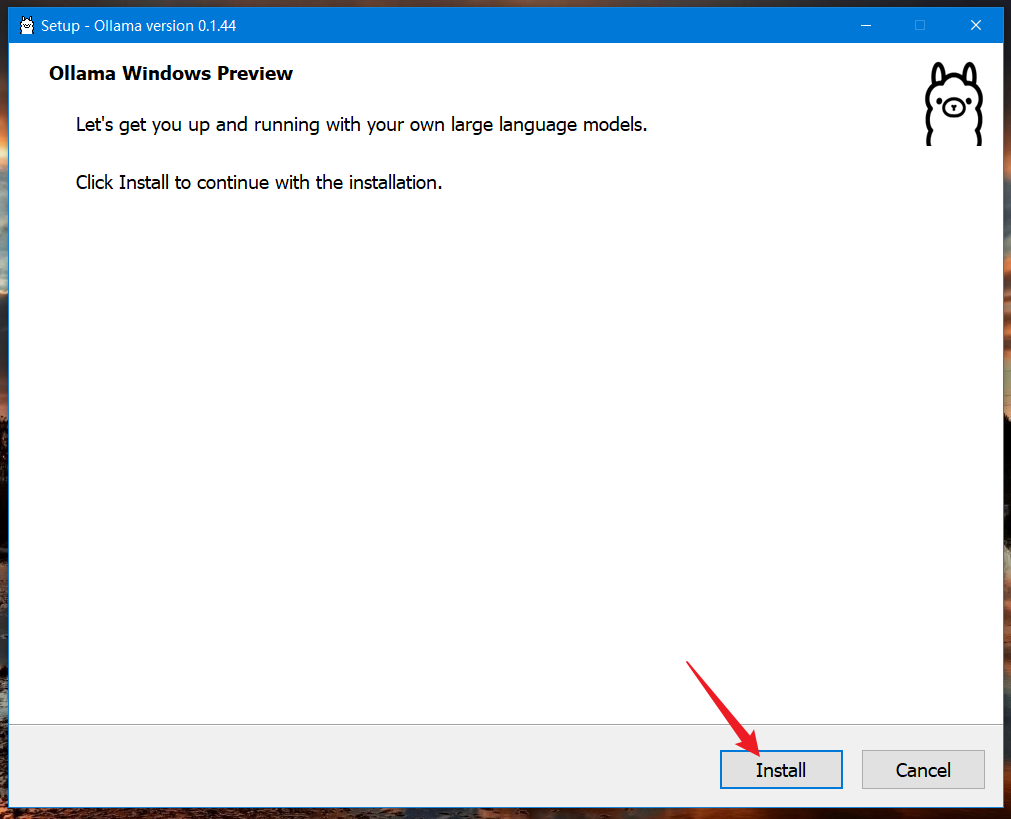

下载到本地后,是一个名为OllamaSetup.exe的安装文件

- 安装

直接双击打开,点击install按钮进行安装。

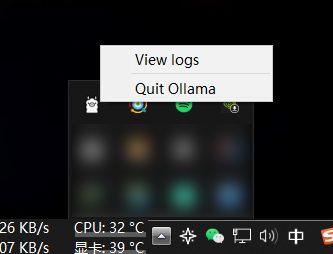

- 退出默认运行

安装完成后,会自动打开Ollama,在右下角右键点击Quit Ollama先将它退出。

- 运行

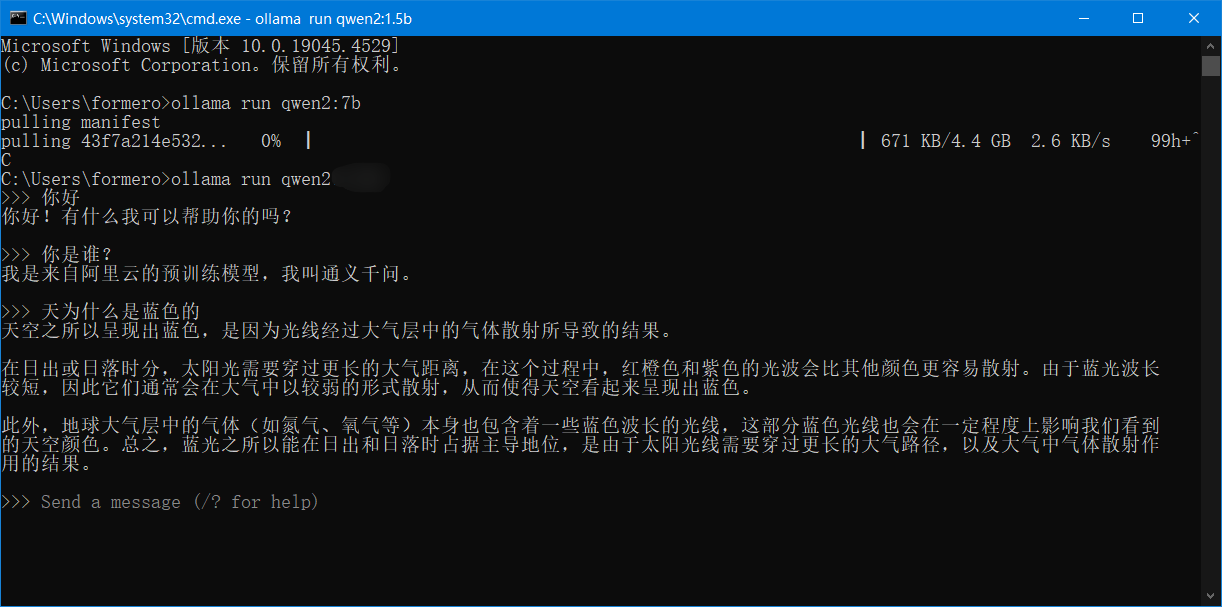

在cmd窗口运行如下命令在运行qwen2大模型,会自动下载需要的模型。

ollama run qwen2国内可能会出现网络问题,下载不下来,需要手动下载并将模型放到如下目录:

C:\Users\用户名\.ollama\models或者配置魔法上网。

- 测试

等待片刻后,出现

>>>Send a message (/? for help)就表示启动成功了。

可以试着问一些问题,如果回复没有问题,就表示安装成功了。

安装现代化图形交互界面窗口

安装Msty进行图形化窗口交互

什么是msty?

msty是一个现代化的交互平台,可以在上面运行流行的各种架构的大模型,支持本地和云端模型。能更好的进行交互。并且可以快速的添加新的模型,同时支持基于文档问答的RAG。

- 安装

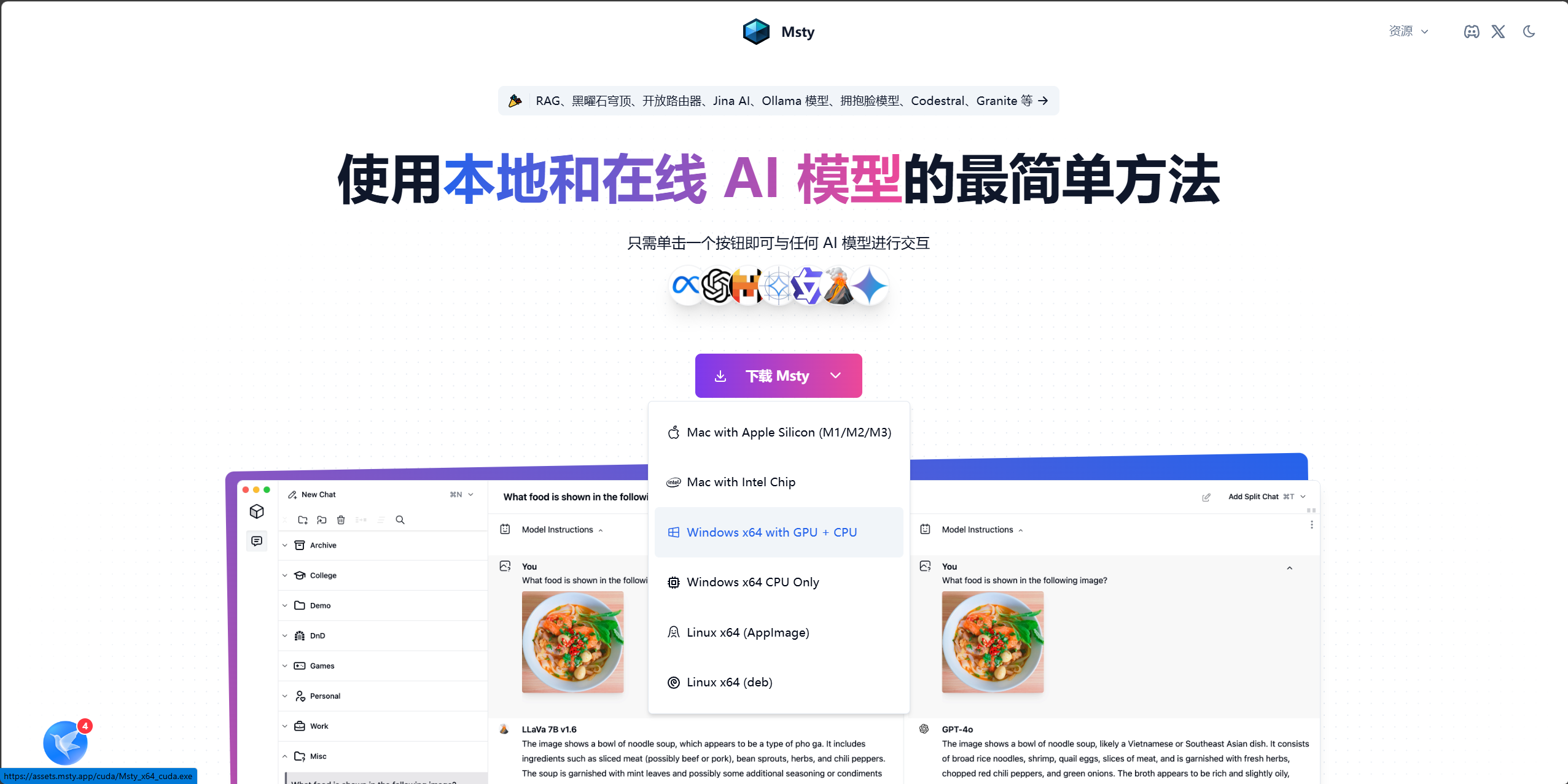

打开Msty官网 https://msty.app/

打开后点击下载按钮下载最新安装文件

Windows 用户且GPU显存大于4G的可以安装我选择的这个,否则选择下载下面那个CPU版。

下载完成后,双击打开,会自动进行安装。

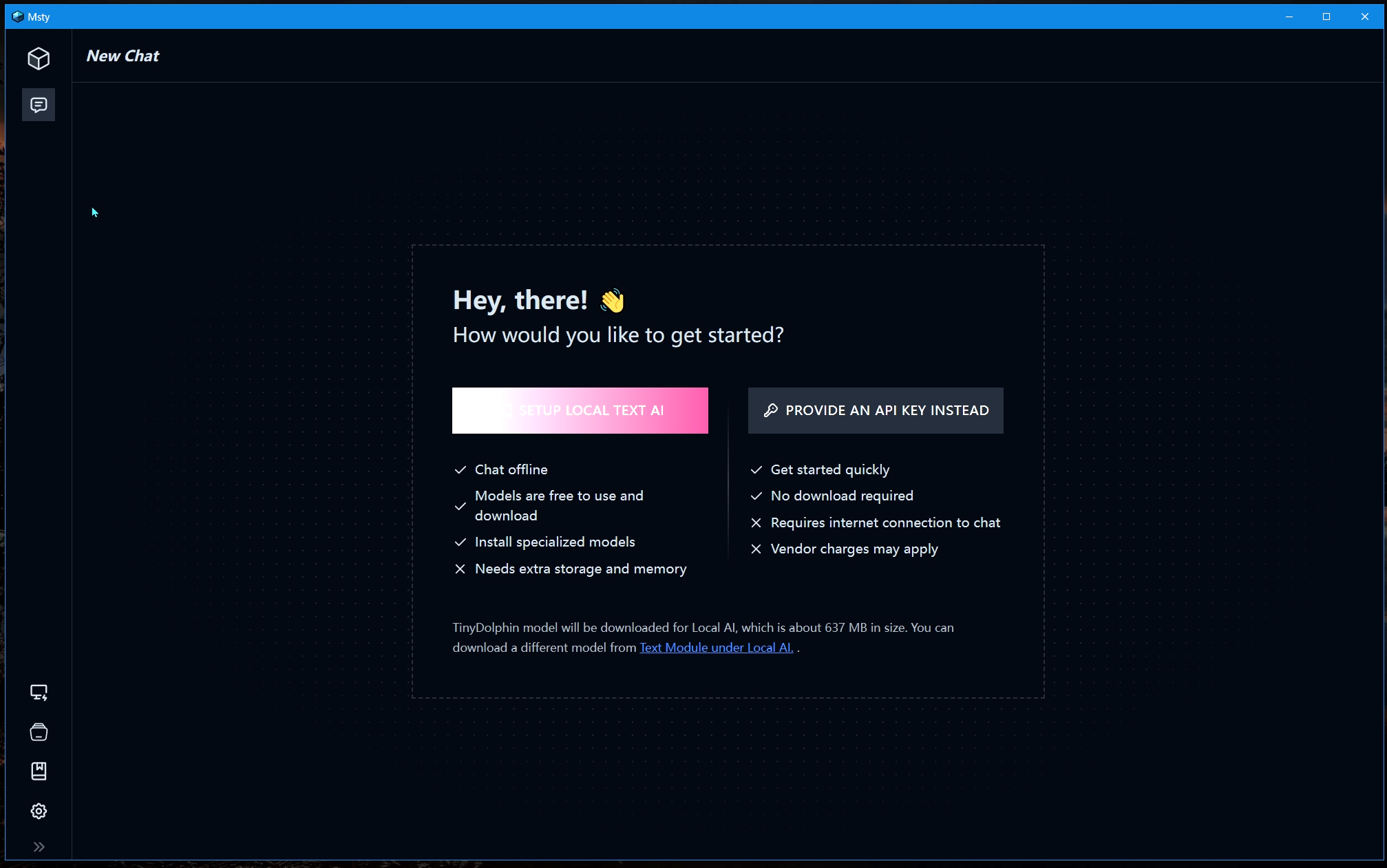

随后跳出如下界面表示,安装成功!

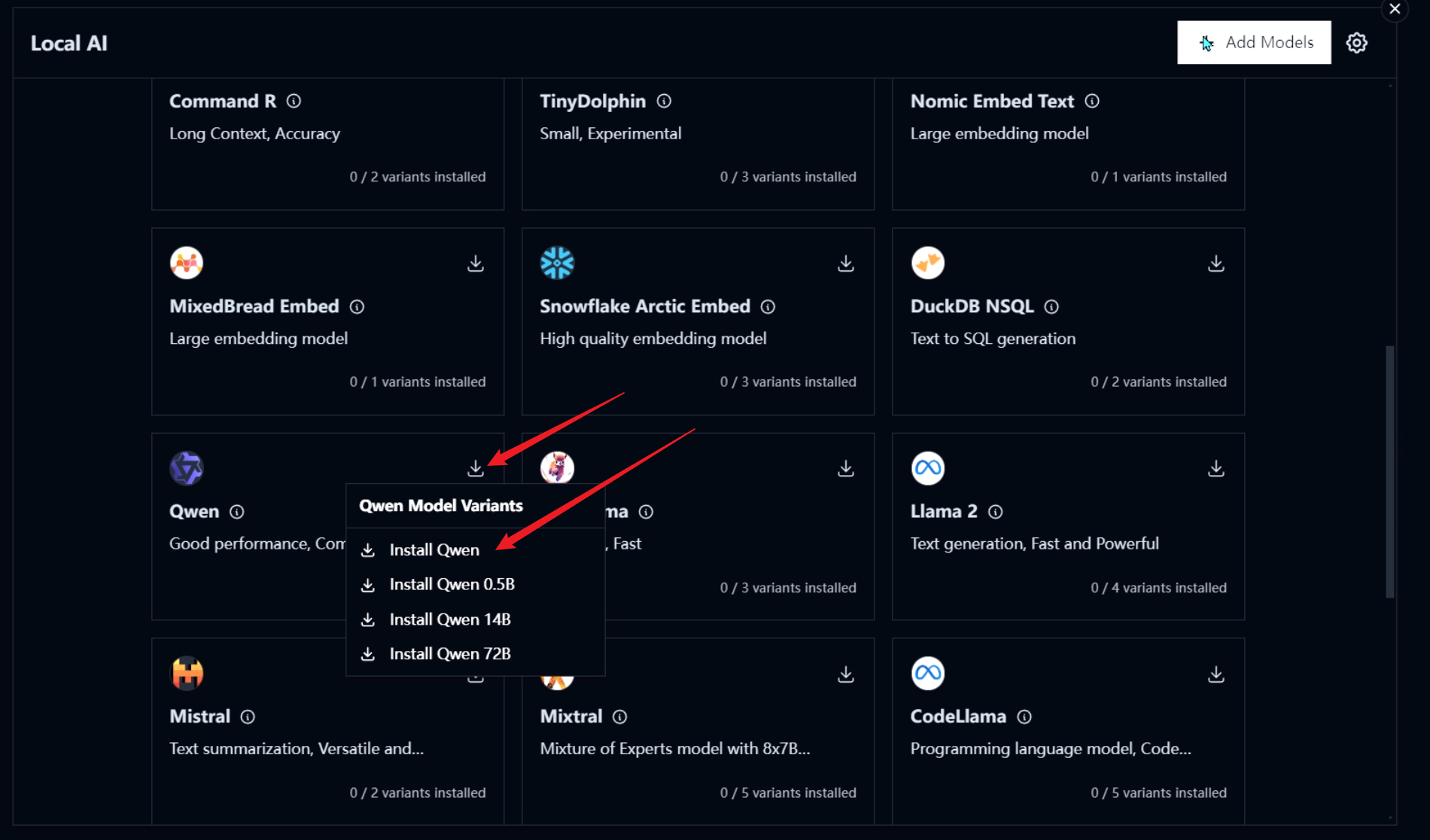

- 配置模型

安装成功后,先不要点击中间的SetUp,它会下载一个TinyDolphin的模型,这个对中文支持的不好,我们直接选择下载Qwen2大模型。

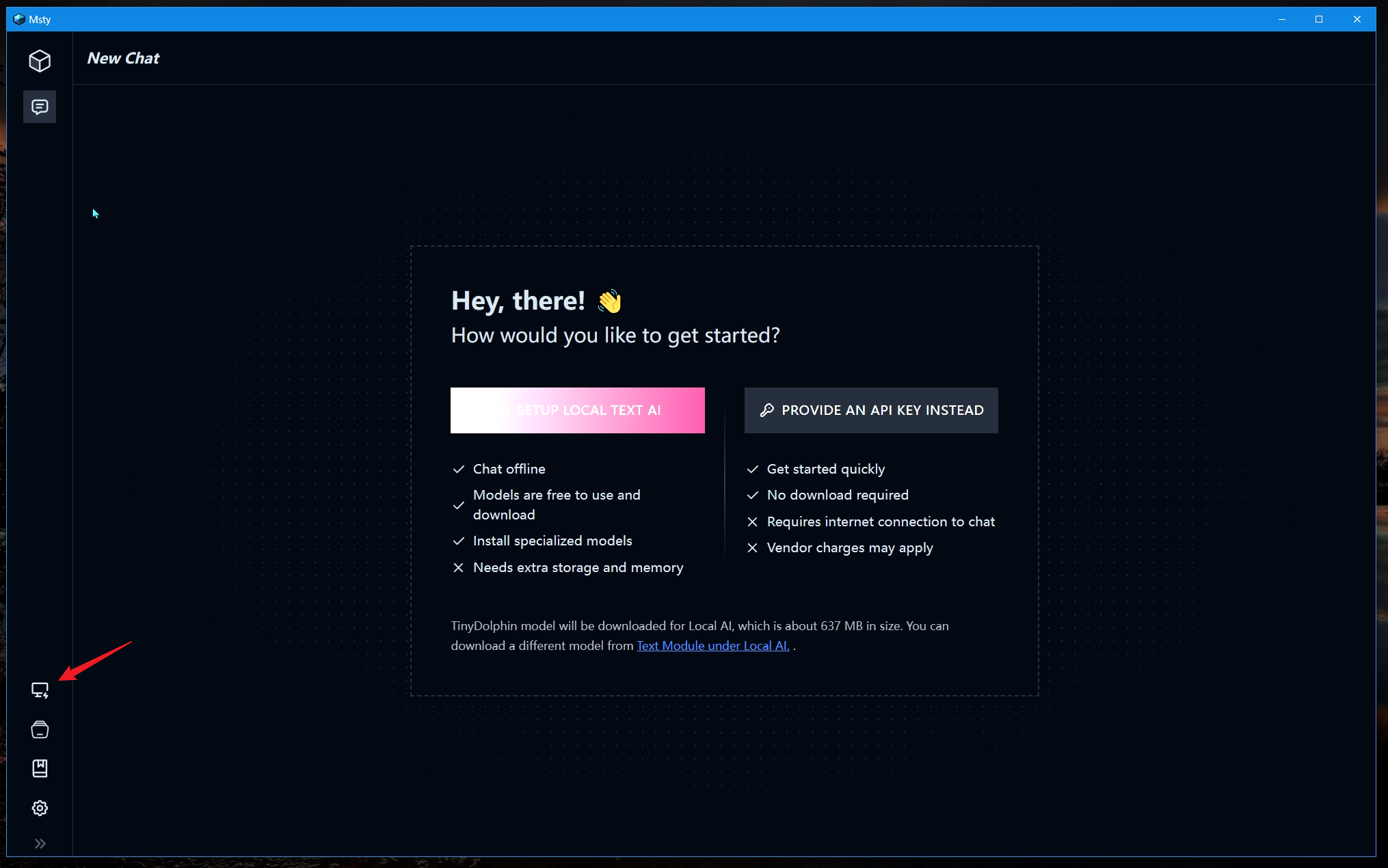

点击这里:

随后找到qwen2模型,点击这个下载按钮:

显存小于4G的可以使用0.5B的小模型,大于4G的可以下载第一个不带参数的,为7B

点击后会自动下载并配置。

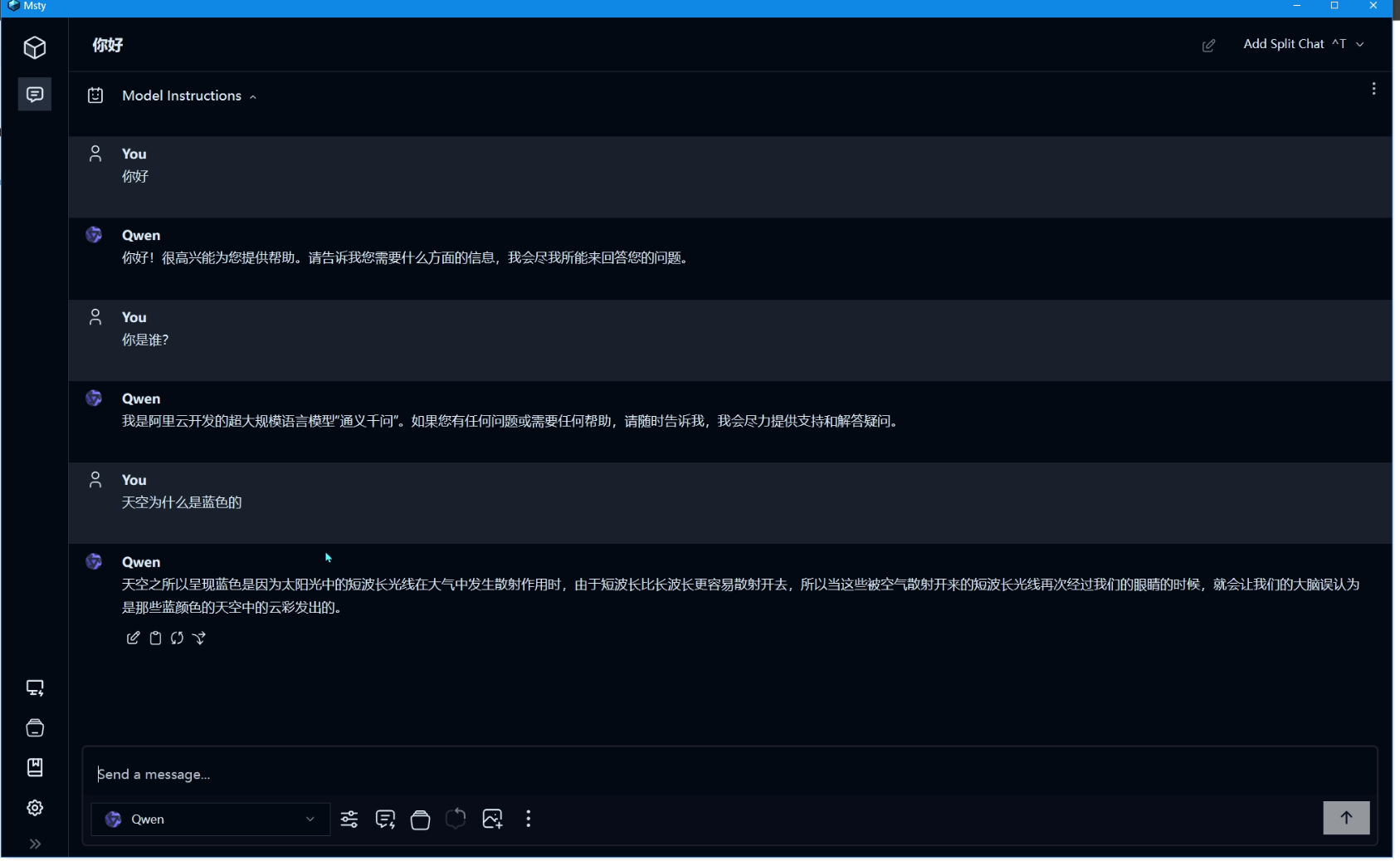

使用

安装完成后,就可以在直接对话进行qwen2的使用了。

试了一下,回复的速度很快,感觉很不错!

这个工具还支持多种不同模型,并且功能很完善,还支持配置API使用云端模型。 更多操作快去自行体验吧。