本文最后更新于1 分钟前,文中所描述的信息可能已发生改变。

Nvidia、Intel与AMD的未来之战

“数百万GPU数据中心的时代即将来临”,Nvidia的CEO黄仁勋在Computex的主题演讲中这样说。Huang的预测越来越大胆,他最近说过,因为AI的存在,程序员将不需要学习编码。 但鉴于他正领导着一个价值数万亿美元的公司,Huang还是可以允许自己做出一些大胆的猜测。

相比之下,处于追赶状态的Intel和AMD在他们的Computex主题演讲中则更加脚踏实地。Intel的Pat Gelsinger和AMD的苏妈更加接地气。

苏妈专注于介绍将摧毁Nvidia王国的新产品。而Gelsinger出人意料地专注于x86的功率效率和将抵御ARM威胁的产品,ARM正威胁着Intel在PC和服务器上的主导地位。

对于Nvidia和AMD来说,AI是一座金矿,公司通过引入到2026年的产品扩展了他们的GPU和CPU路线图。Intel的GPU路线图岌岌可危,Intel的Ponte Vecchio GPU已经宣布死亡,而它的Falcon Shores GPU正在经历重新设计后复活。

Intel转而专注于其新的Xeon6E核心芯片,这些芯片因其出乎意料的功率效率增益而受到好评。

Nvidia的GPU

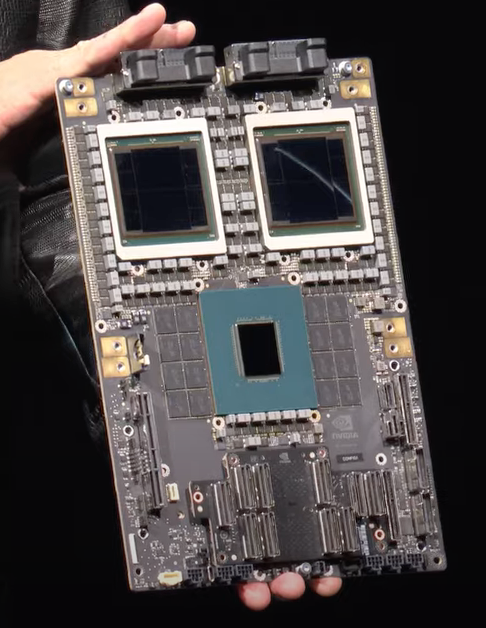

Nvidia为2026年的路线图增加了新的GPU、CPU和网络芯片。2026年的“Rubin”平台GPU将支持HBM4内存,这需要密集的内存配置。到2027年,公司计划推出Rubin Ultra,这是一个增量升级,也将使用HBM4。

Rubin GPU将支持12插槽服务器,相比目前的八插槽服务器。

“我们将一切推向技术极限,无论是TSMC工艺……无论是什么内存技术……SERDES技术,光学技术,一切都被推向极限,”Nvidia CEO 黄仁勋在他的主题演讲中说。

Huang正在用Rubin升级整个芯片堆栈。在2026年,Nvidia将引入一款名为Vera的新CPU,它将与Rubin搭配使用。Vera将接替目前与Hopper和Blackwell GPU配对使用的Grace CPU。

Nvidia还引入了NVLink 6互连,用于连接机架和数据中心中的GPU。

路线图显示,它的速度将达到3600 GB/秒,大约是目前Blackwell中NVLink 5速度1800GB/秒的两倍。NVLink是一种专有的芯片到芯片互连。

Rubin平台还将网络速度提高一倍,以扩展数据中心中GPU通信的速度到1600GB/秒,这是前代产品速度的两倍。CX9 苏妈perNIC网络接口和x1600 Ethernet/Infiniband网络接口将允许数百万GPU进行通信。

Rubin将接替2025年的Blackwell Ultra GPU,后者将是今年推出的Blackwell GPU的升级。Blackwell Ultra包括HBM3e支持,并支持800GB/秒的X800网络接口。

“X800 Ultra设计用于数十万GPU,而X1600设计用于数百万GPU。数百万GPU数据中心的日子即将来临,”Huang说。

Blackwell即将推出,并将在Nvidia的DGX风冷和液冷系统中可用。风冷系统将可用于x86 CPU。

所有主要云提供商已经宣布Blackwell GPU和系统的可用性。微软表示,Azure云中的Blackwell首个实例将在今年晚些时候上线。

AMD的GPU

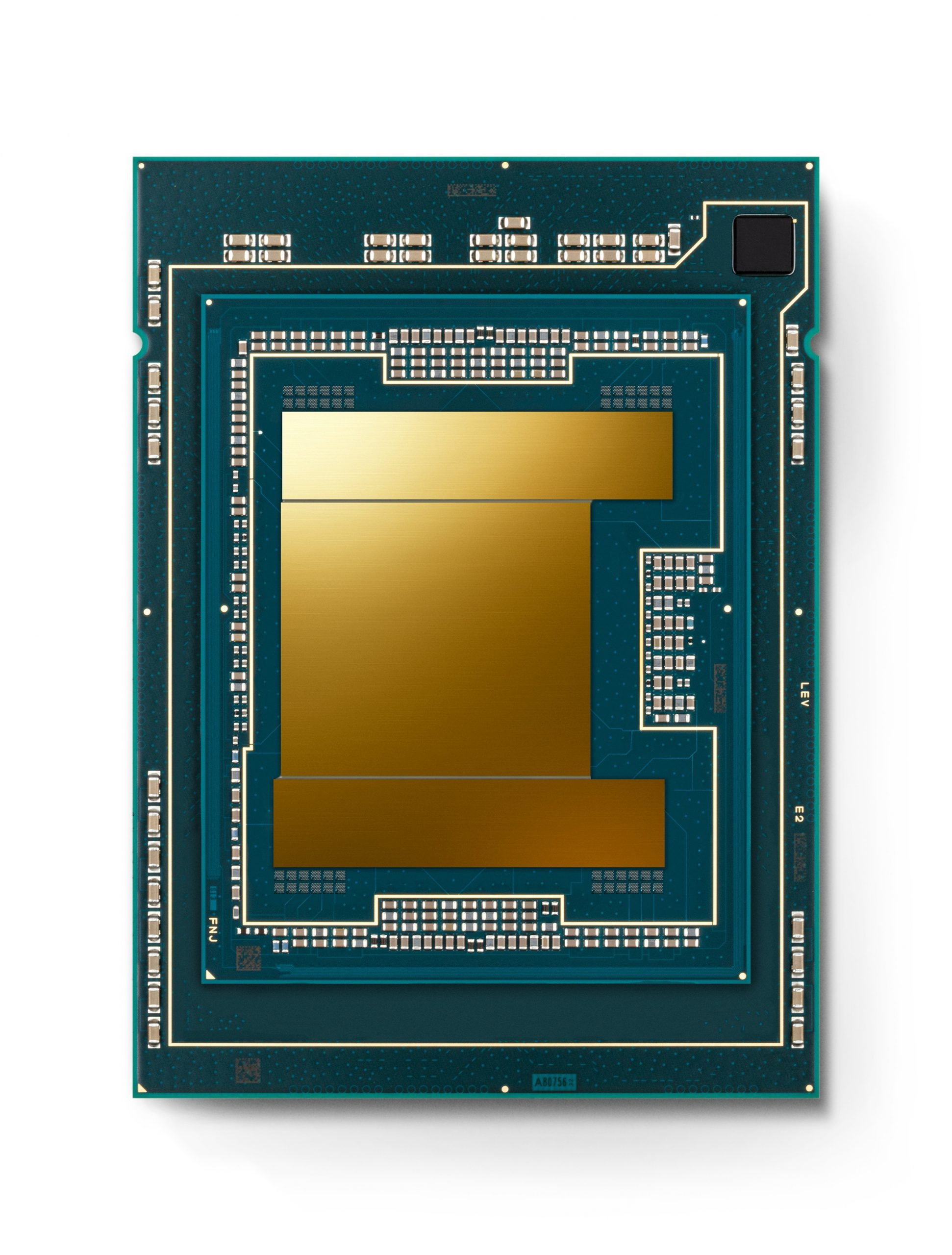

AMD CEO苏妈在宣布新GPU时直接对Nvidia发起了攻击。AMD凭借MI300取得了成功,它被微软、Meta和甲骨文云采用。微软CEO Satya Nadella表示,MI300X为GPT-4工作负载提供了最佳的性价比。

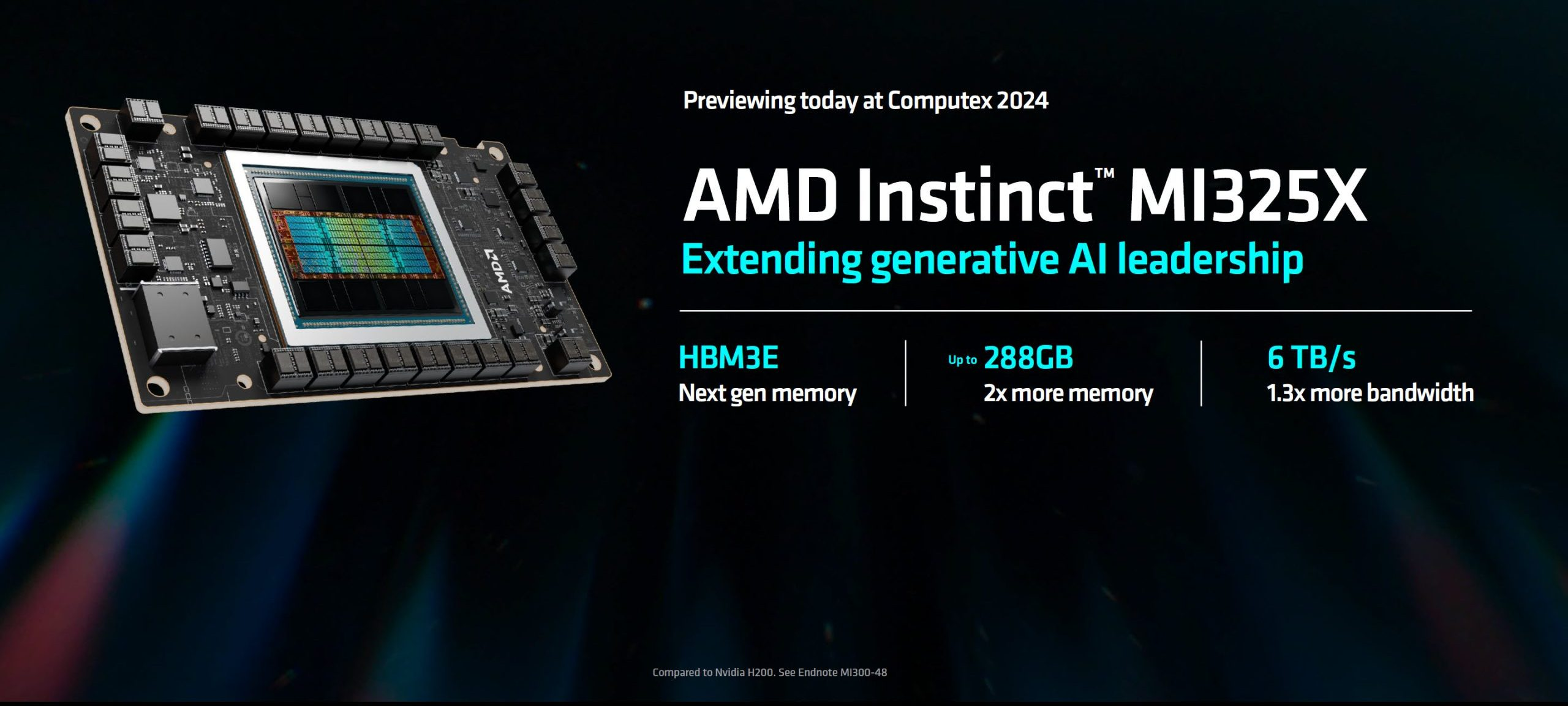

下一个主要的GPU将是MI325X,它是今年年底之前将推出的MI300X的升级版。它将包括288GB的HBM3E内存——Nvidia已经在H200中使用了——和六TB每秒的内存带宽。

“一台配备八个MI325加速器的单服务器可以运行高达1万亿参数的高级模型。这是H200服务器支持的大小的两倍,”AMD CEO 苏妈说。

到2025年,AMD将发布基于HBM3e的MI350系列,它将使用3纳米工艺制造。GPU将基于新的CDNA-4架构,这是为AI调优的。

“当我们推出CDNA-3时,我们的AI性能比上一代提高了八倍。而随着CDNA-4,我们正走在实现35倍增长的道路上,”苏妈说。

MI325X和MI350X系列将支持通用基板OCP服务器设计,“这意味着我们的客户可以非常快速地采用这项新技术,”苏妈说。

相比之下,Nvidia的GPU对普通客户来说并不容易从货架上直接购买。

到2026年,AMD将推出MI400 GPU,尽管苏妈没有过多谈及,只是说它将基于CDNA-Next架构。

AMD还推出了代号为Turin的第五代Epyc CPU,它将采用3纳米和6纳米芯片,并将在今年晚些时候上市。它将拥有多达192个核心和384个线程。

Intel的芯片

在主题演讲中,Intel的CEO Pat Gelsinger一如既往地诚实,他专注于介绍代号为Sierra Forest的Xeon 6 E服务器芯片和代号为Lunar Lake的PC芯片。没有GPU,也没有宏大的宣言。

Gelsinger给人的感觉是,Intel正在用其新一代的服务器和PC芯片重新回到CPU游戏中,这些芯片在保持性能领先的同时,功耗更低。

Xeon 6 E核心芯片针对的是拥有大量CPU核心的功率效率服务器市场,这个市场正好符合ARM的特点。微软、谷歌和亚马逊已经推出了基于ARM架构的功率效率CPU。

Xeon 6 E核心芯片有多种配置,最高可达288个核心。这些芯片在Serve The Home和Phoronix上获得了好评。这两个网站都有经验丰富、可靠的评论员,他们在多种工作负载和操作系统上测试硬件的经验丰富。

评论的总体感受是惊讶——x86芯片能够以合理的功率效率提供性能,这一直是ARM的卖点。

“我们认为这对现代数据中心来说是一次必要的升级,具有高核心数、高密度和卓越的性能每瓦。也重要的是,这是我们在Intel 3上的第一款产品,而Intel 3是我们四年内五个节点中的第三个,”Gelsinger说。

Gelsinger还说,Intel正在打破x86功耗高的神话,其Lunar Lake PC芯片比前一代Meteor Lake PC芯片的功率效率提高了40%。

苹果的Mac基于ARM技术,其电池寿命几乎是搭载x86芯片的Windows PC的两倍。高通最近推出的Snapdragon X Elite芯片也宣称为Windows PC提供了多天的电池寿命。

“有人说x86在功率效率上无法胜出。Lunar Lake也打破了这个神话。这种激进的新SOC架构和设计带来了前所未有的功率效率,比Meteor Lake的SOC性能低40%,而Meteor Lake已经非常好了,”Gelsinger说。